Using Kafka

Para executar o Apache Kafka localmente nós utilizaremos três containers (Kafka, Zookeeper, Kafdrop) organizados dentro de um arquivo chamado “Docker Compose”.

Após iniciar os containers aguarde alguns minutos e utilize qualquer ferramenta compatível com o Apache Kafka para se conectar usando a porta tcp 29092. Para facilitar o teste no ambiente de desenvolvimento esse arquivo do Docker Compose traz a ferramenta Kafdrop.

Siga os passos abaixo para iniciar a utilização do kafka:

- Clonar o repositório

git clone https://github.com/devprime/kafka - Para iniciar

docker-compose up -d - Listar os três containers ativos

docker ps - Para finalizar

docker-compose down

Iniciando a configuração dos tópicos no Kafka

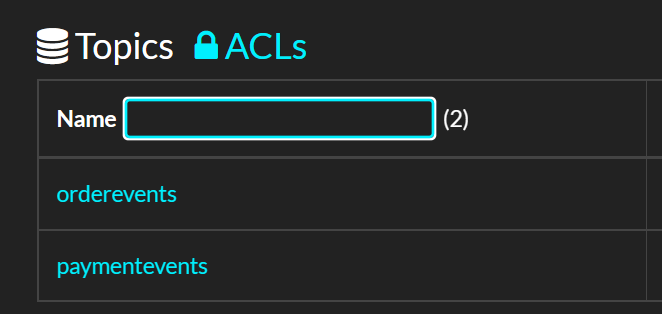

Os microsserviços baseados no Devprime se conectam automaticamente nos serviços de Stream como o Kafka e nos exemplos utilizamos alguns tópicos padrões como orderevents e paymentevents.

- Abra o Kafdrop no browser em http://localhost:9000

- Vá na opção “Topic” e New adicionando “orderevents” e depois “paymentevents”

- Verifique os tópicos criados

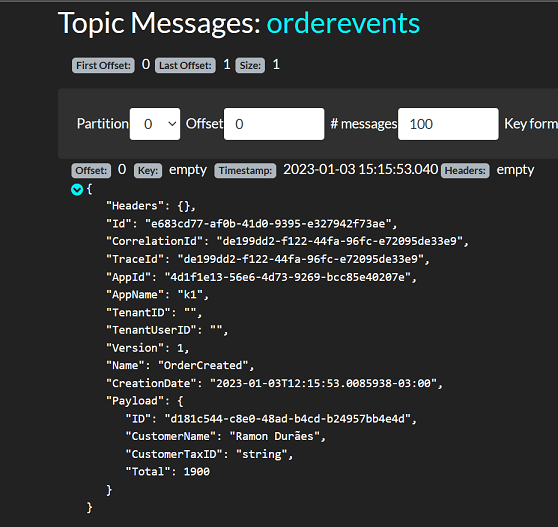

Visualizando mensagens no Kafka

Ao utilizar o microsserviço enviaremos eventos pelo Kafka e visualizaremos por meio da ferramenta Kafdrop clicando no tópico e depois em “View Messages”.